- merci! Utile

- Pas utile

- Pas sûr

chargement des résultats

chargement des résultats

La solution que j’utilise depuis plusieurs mois s’appelle MacWhisper. Comme son nom l’indique, c’est une application pour Mac qui utilise le modèle Open Source Whisper d’OpenAI. L’interface de l’outil est perfectible et il manque la détection automatique des participants (il faut les indiquer à la main pour l’instant) mais la qualité de transcription est excellente en anglais et très bonne en français (au début il faut tester avec les différents modèles pour voir ce qui convient le mieux à chaque situation mais une fois qu’on est calé, c’est super et surtout très rapide). Sur les interviews pour lesquelles j’ai utilisé MacWhisper (plusieurs dizaines d’heures en anglais et en français, avec différents accents), j’ai trouvé les résultats bien meilleurs qu’avec Dovetail par exemple.

La solution que j’utilise depuis plusieurs mois s’appelle MacWhisper. Comme son nom l’indique, c’est une application pour Mac qui utilise le modèle Open Source Whisper d’OpenAI. L’interface de l’outil est perfectible et il manque la détection automatique des participants (il faut les indiquer à la main pour l’instant) mais la qualité de transcription est excellente en anglais et très bonne en français (au début il faut tester avec les différents modèles pour voir ce qui convient le mieux à chaque situation mais une fois qu’on est calé, c’est super et surtout très rapide). Sur les interviews pour lesquelles j’ai utilisé MacWhisper (plusieurs dizaines d’heures en anglais et en français, avec différents accents), j’ai trouvé les résultats bien meilleurs qu’avec Dovetail par exemple.

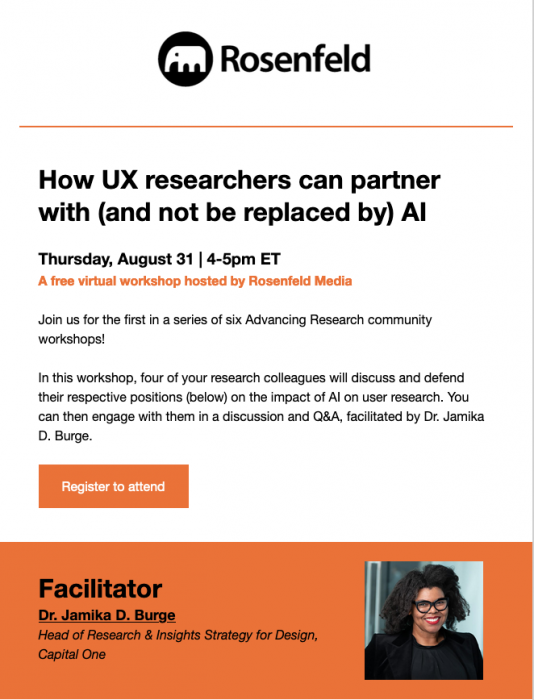

Lien d'inscription: https://us02web.zoom.us/meeting/register/tZ0rde2upjwsHtCC_IOHK6aeY01wWHBnne6H?mc_cid=5cad4cd451&mc_eid=fc3b5fcc9f#/registration

Lien d'inscription: https://us02web.zoom.us/meeting/register/tZ0rde2upjwsHtCC_IOHK6aeY01wWHBnne6H?mc_cid=5cad4cd451&mc_eid=fc3b5fcc9f#/registration

Dans ce groupe posez vos questions et partagez vos astuces, ressources, outils, jobs etc sur la recherche utilisateur!

Un groupe pour poser vos questions et partager vos astuces, ressources, outils, et actualités sur le product design.

Un groupe pour poser vos questions et partager vos astuces, ressources, outils, et actualités sur l'accessibilité numérique.

Un groupe pour poser vos questions et partager vos astuces, ressources, outils, et actualités sur l'utilisation des sciences cognitives dans le monde produit.

Un groupe pour poser vos questions et partager vos astuces, ressources, outils, et actualités sur l'éthique dans le monde produit.

Un groupe pour poser vos questions et partager vos astuces, ressources, outils, et actualités sur la green UX qui comprend l'éco-conception et la sobriété numérique.

Un groupe pour poser vos questions et partager vos astuces, ressources, outils, et actualités sur l'UX writing.

Un groupe pour poser vos questions et partager vos astuces, ressources, outils, et actualités sur la vie de freelancer.

Groupe pour partager les offres d'emplois, et de missions freelance en France ou ailleurs ainsi que de discuter de nos choix de carrières. Postage libre aux professionnels UX. Pas de recruteurs/RH.

Dans ce groupe posez vos questions et partagez vos astuces, ressources, outils, et retours d'expériences sur la facilitation d'ateliers, de réunions.

Dans ce groupe posez vos questions et partagez vos astuces, ressources, outils, jobs et plus encore sur le sujet de la stratégie UX.

Un groupe pour fédérer tous ceux qui enseignent l'UX afin de partager vos questions ressources et astuces.

Dans ce groupe posez vos questions et partagez vos astuces, ressources, outils, jobs et plus encore sur le sujet du management d'équipes UX.

Un groupe pour regrouper les questions, astuces, REX, outils et ressources sur l'utilisation de l'intelligence artificielle dans les métiers de l'UX.